ACGN 领域最具影响力的产业新媒体

访问三文娱网站3wyu.com查看产业必读文章

几个月前,网络上便出现了一个台湾艺术家所做的面部捕捉测试。目前, Kite&Lightning游戏工作室的创始人 Cory Strassburger在Youtube上发布了一系列更为系统、全面的测试。

作者:xuan

iPhone X上市后,相信不少用户已经在社交网络当中晒过一轮“独家定制”的Animoji了。这款iPhone新产品的上市,引起了新一轮的购买狂潮,而其所推出的Animoji功能更是被很多人称之为iPhone X最容易让人玩上瘾的功能。

不过在Animoji风靡全球的同时,有用户对iPhone X前置摄像头进行研究,并发现了新玩儿法。

对于动画艺术家来说,苹果iPhone X是一个超出所有人想象的一个强大工具。而这种强大要归因于苹果前置摄像头的True Depth系统,以及苹果的ARKit API。 ARKit是Apple官方提供开发者使用的一个API接口工具。

通过ARKit,开发者能直接利用现成的框架,更容易地在自己的app上开发AR增强现实类功能。API中包括52个不同的面部跟踪运动组,这也让动画制作者能够将手机变成一个特别的性能捕捉系统。

几个月前,网络上便出现了一个台湾艺术家所做的面部捕捉测试。目前, Kite&Lightning游戏工作室的创始人 Cory Strassburger在Youtube上发布了一系列更为系统、全面的测试。

Kite & Lightning是一家专注于互动视频和游戏内容领域的工作室,他们总部坐落于洛杉矶。去年,这家游戏工作室发布了一款沉浸时迷你歌剧《Senza Peso》,其中也使用到了眼部追踪技术。

他们也投资开发了一款全新的VR游戏:Bebylon Battle Royale: A Gentleman’s Game(宝贝大逃杀:绅士游戏)。

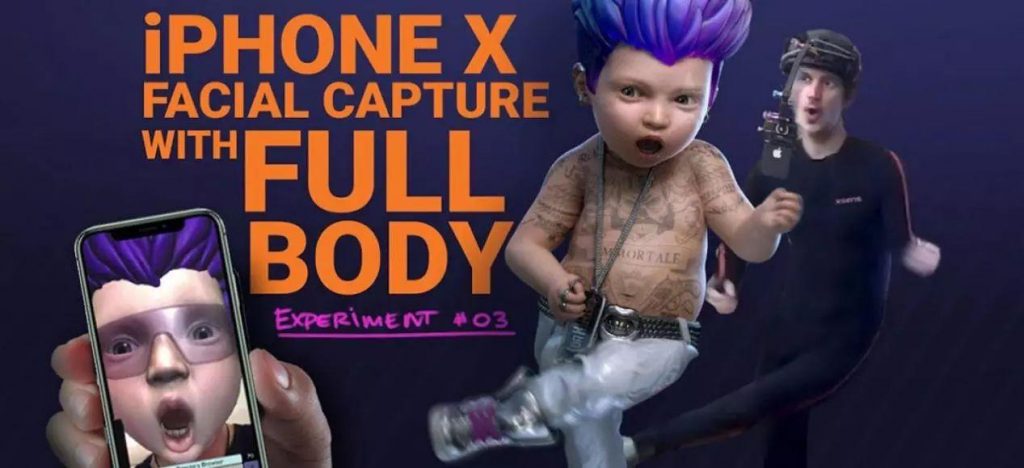

现在,该公司在iPhone X上的测试也让用户感受到了不一样的体验。 通过使用一部iPhone X,一个为手机设计的一个定制应用,一个自制的头盔设备,以及一套Xsens MVN( 惯性动作捕捉系统)性能捕捉套装,Strassburger给大众展示了iPhone X更深层级的玩法概念。

Strassburger在视频中解释说,他想看看iPhone X能否用于VR游戏中便宜又快速的面部动作捕捉,这种功能正是那些疯狂痴迷于游戏,想要表现自己的孩子们目前最需要、最想操控的。

同时,他也想知道能否通过iPhone X的面部捕捉系统,快速、便捷地为游戏中的人物加入个性化色彩。

Strassburger的第一个测试是一个粗糙的面部捕捉测试。他在Unity中导入《 Beblon Battle Royle》的一个游戏角色,并将ARKit输出的面部捕捉数据混入该角色中。

iPhone X面部表情捕捉测试

在第二次测试中,Strassburger增加了眼球追踪、头部运动等更加细节的部分,并将iPhone X上记录的面部动画数据导入Maya。

在看到Youtube上的一名评论者询问如何从手机中提取面部数据后,Strassburger回应其实这个操作非常简单。

Strassburger使用的是Unity。作为全球最流行的引擎之一,目前市面上的上大部分移动虚拟现实应用程序都是采用Unity进行开发的。

Unity目前已经与苹果联手合作,确保在苹果硬件上实现Unity开发的最佳集成。

Strassburger从游戏中导入了一个角色,然后用51channel的数据与之相连接,以确保他可以在捕捉的过程中看到这个角色。

然后,Strassburger开发了一款应用,将数据记录到iPhone本地的文本文件中,之后,他从苹果中复制了文件,通过他自己编写的一个转换器来运行它,并将文本文件解析为Maya.anim文档。

把这些文档导入Maya和游戏角色中,用户在手机上呈现的表情,便出现在游戏角色上了。

iPhone X面部表情捕捉测试第2部分—Maya数据测试

在Strassburger最近的测试中,他结合使用Xsens紧身衣裤来获取面部和全身捕获:

iPhone X面部捕捉测试第3部分-全身测试

Strassburger演示成果的质量也让人们看到了除动作捕捉之外其他功能实现的可能性。尤其是在增强现实领域内,这种应用可能会起到至关重要的作用。

例如,利用这种角色人物来进行实时视频聊天似乎也成为一个在近期可能会实现的技术。